基本原理

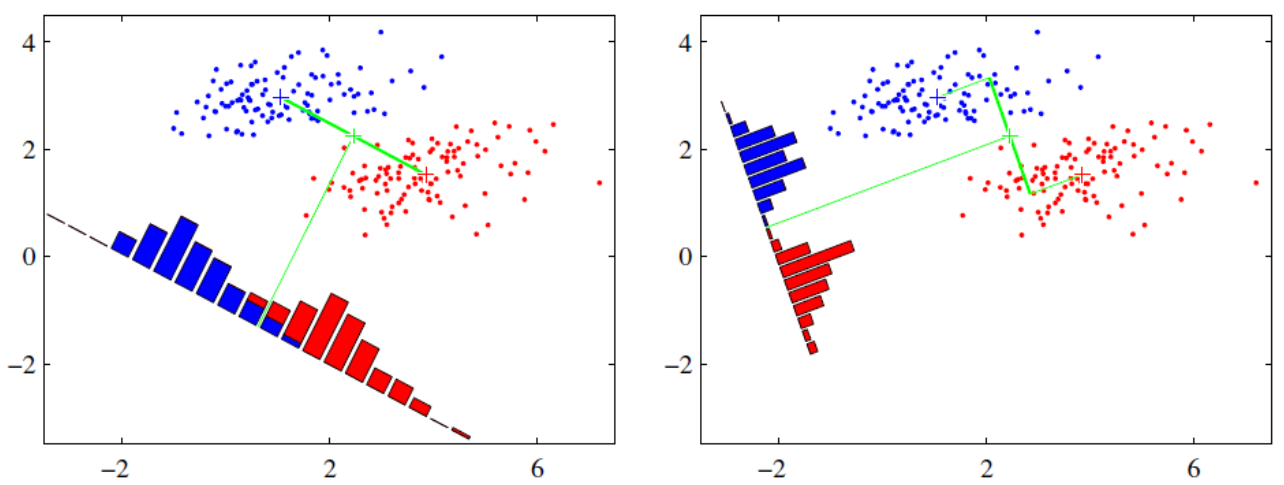

降维原理:组间方差大、组内方差小。

降维步骤

以二类数据为例对降维过程进行说明。首先,定义如下变量:

- 数据集:

- 类别:

原始数据为

投影

使用向量

计算原始数据类内均值

计算投影后的样本点均值

由此可知,投影后的均值是样本中心点的投影。

定义投影后数据的方差:度量组内差异

为方便后续计算,定义中间部分为:

这也被称为散列矩阵(scatter matrices)。

定义

定义投影后组间均值差异:度量组间差异

定义

定义最终度量公式

定义优化目标

增加约束

定义拉格朗日函数

求导得:

解得:

可见,

因为:

而

那么:

所以:

至此,只需要求出原始样本的均值和方差就可以求出最佳的方向

参考链接

- 线性判别分析LDA原理总结 - 刘建平Pinard - 博客园 (cnblogs.com)

- 为什么线性判别分析的降维维数不能大于类别数减一? - 知乎 (zhihu.com)

- Dimensionality Reduction——LDA线性判别分析原理篇 - 知乎 (zhihu.com)

- Linear Discriminant Analysis (sebastianraschka.com)