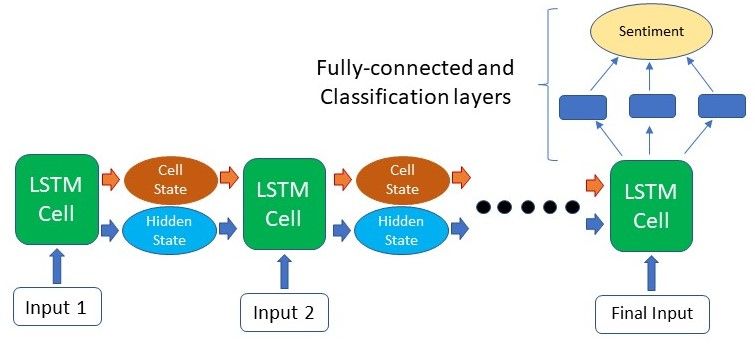

LSTM简介

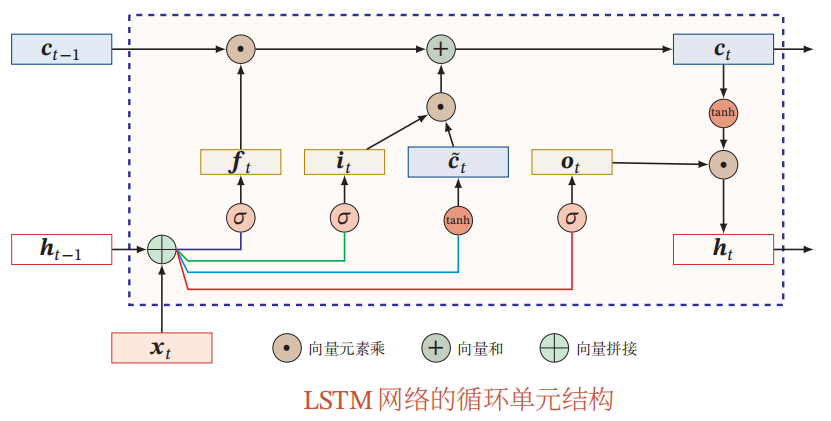

LSTM单元结构

输入

候选状态

门

遗忘门:对

输入门:对

输出门:对

三个门的计算方式为:

输出

Pytorch LSTM

模型参数

- input_size: 输入数据的特征个数

- hidden_size: hidden state的个数

- num_layers: RNN网络的层数,以下默认为1。

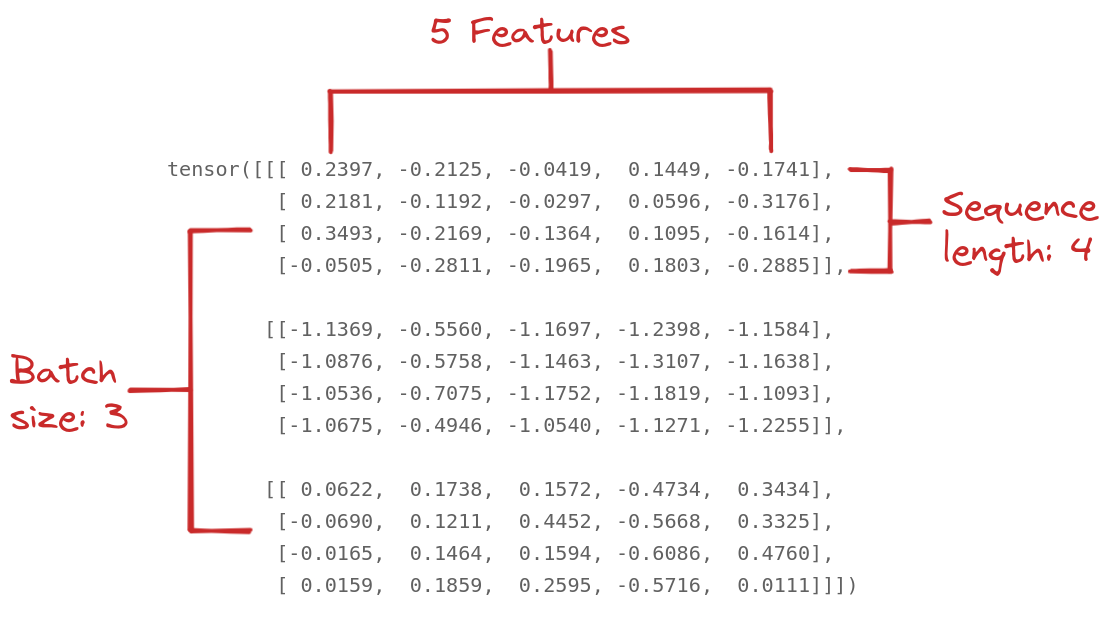

- batch_first: 如果为true,则输入数据的shape为(batch_size, seq_len, feature_num)。以下默认为true。

输入

input

batch_size * seq_len * feature_num

num_layers * batch_size * hidden_size

num_layers * batch_size * hidden_size

输出

output

batch_size * seq_len * hidden_size

num_layers * batch_size * hidden_size

num_layers * batch_size * hidden_size

参考文档